High Performance Computing Testbed

Motivation

Moderne und schnelle Hardware ist die Grundlage von angewandter Forschung, speziell im Bereich von AI/ML Anwendungen. Das High Performance Computing Testbed (HPC) des DAI-Labors bietet Forscher*innen als auch Studierenden die notwendigen Ressourcen, ihre innovativen Ideen in die Tat umsetzen zu können. Durch das HPC profitieren sie von aktuellen leistungsfähigen Servern mit der Fähigkeit, auch große Datenmengen an Foto- und Video-Daten effizient verarbeiten zu können.

Technologie

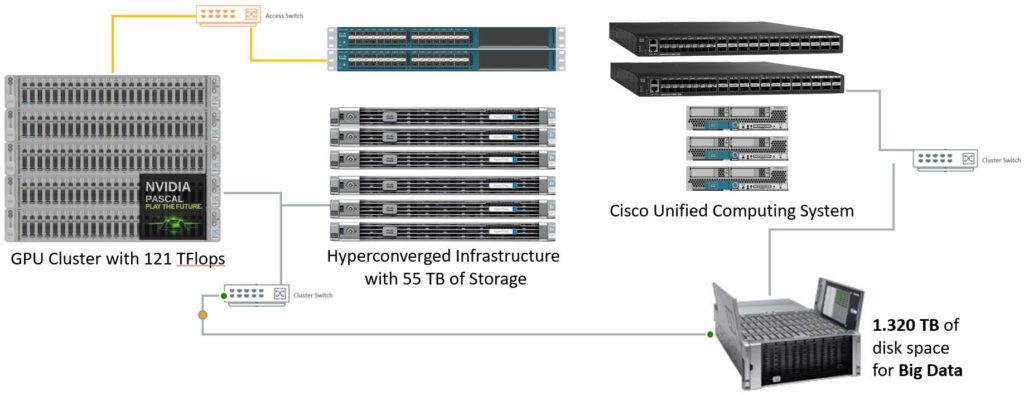

Das HPC ist ein mächtiges Werkzeug zur Durchführung rechenintensiver Forschungsarbeiten. Die verschiedenen aufeinander und auf dieses Szenario abgestimmten Komponenten erlauben es, selbst eigene komplexe Modelle mit Maschinellem Lernen zu trainieren. Im Bereich von BigData übersteigen viele Datensätze die Kapazität eines einzelnen Systems, daher besteht das HPC aus vielen verschiedenen Komponenten, die je nach Bedarf über ein internes Netzwerk mit hoher Bandbreite zusammen geschaltet werden. Mehrere Datenspeicher können zur Ablage von Daten genutzt werden, die aber trotzdem jederzeit über das Hochgeschwindigkeitsnetzwerk dort zur Verfügung stehen, wo sie gebraucht werden.

Das HPC Cluster besteht aus CPU und GPU Nodes, welche durch ein Storage System ergänzt werden. Wir setzen auf ein HPC Cluster mit NVIDA Pascal-Chips, welche sich dank ihrer hohen Rechenleistung und Effizienz besonders gut fürs High Performance Computing und Deep Learning eignen. Insgesamt stehen 6 GPU Nodes mit 12 Nvidia P100 bzw. V100 Karten zur Verfügung. Zusammen stehen über 46.000 GPU Cores und theoretische 121 TFLOPS für Single Precision Arithmetik für Berechnungen zur Verfügung. Um auch größte Daten speichern zu können, stehen den Forschern Storage Syteme mit mehr als 1 Petabyte Speicherplatz zur Verfügung.